Готовы получить продающий сайт / рекламу / брендинг?

- Прогнозируемые

- Системные

- Стабильные

Продажи

через Интернет

.webp)

Еще несколько лет назад SEO было предсказуемым. Достаточно было подобрать ключевые слова, создать соответствующий контент, оптимизировать страницу — и вы имели все шансы попасть в топ выдачи Google. Но 2025 год изменил правила игры. На сцену вышел AI Mode — новый режим поиска, в котором традиционное SEO оказалось на грани исчезновения. И это уже не просто апгрейд алгоритма. Это — фундаментальная трансформация самого понятия поиска.

Содержание

В прошлом месяце на SEO Week, во время доклада «Brave New World of SEO», Майкл Кинг еще раз подчеркнул: да, сейчас между органической выдачей и AI Overviews существует значительное пересечение. Но мы совершенно не готовы к тому, что будет, когда к этому добавятся память, персонализация, MCP (Multisearch Central Protocol) и обязательные агентные возможности. С анонсами новых функций в AI Mode все, о чем говорил Майкл Кинг, уже стало частью опыта поиска Google — или станет им до конца года.

В этой статье мы разберем:

AI Mode — это не просто еще одна фича Google. Это полностью новый режим, в котором поиск перестает быть списком ссылок и превращается в обобщенный, логически построенный ответ. Вы открываете Google и задаете вопрос, но то, что происходит дальше, уже не похоже на привычный поиск. Нет синих подчеркиваний. Вместо этого — дружественный, контекстно-зависимый абзац, который отвечает даже на то, что вы еще не успели спросить.

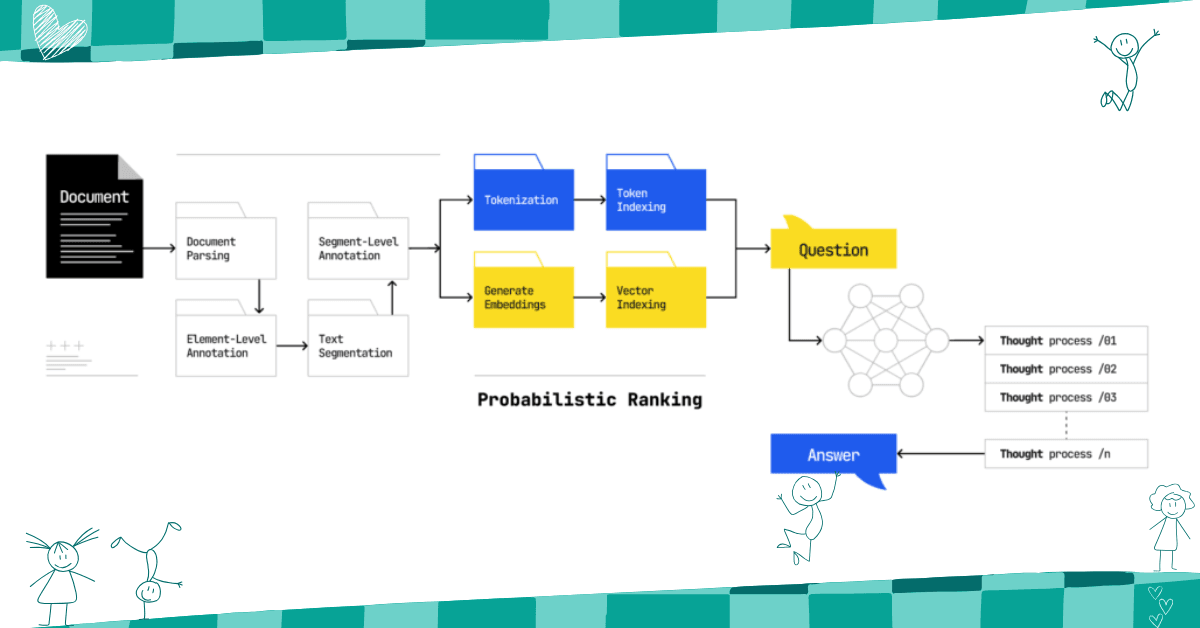

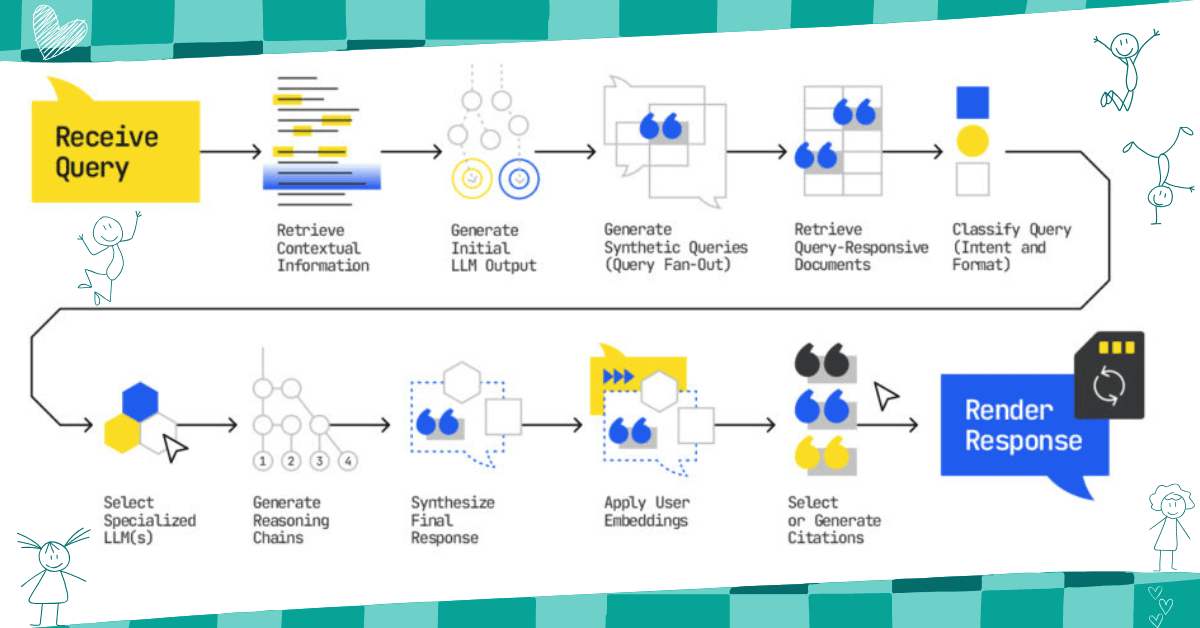

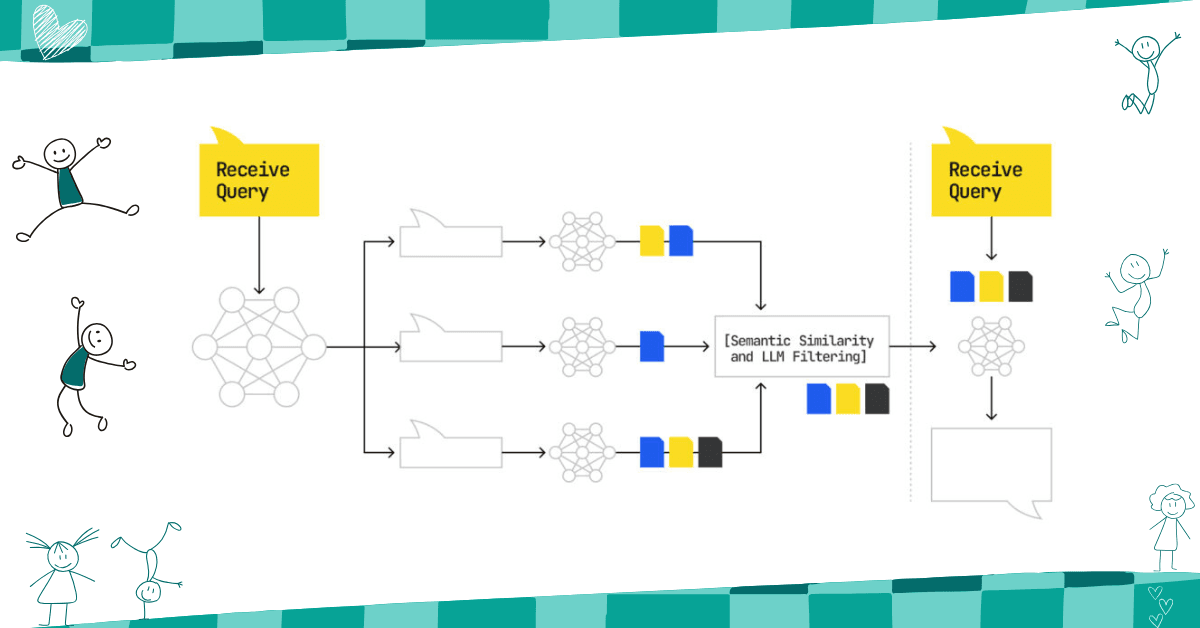

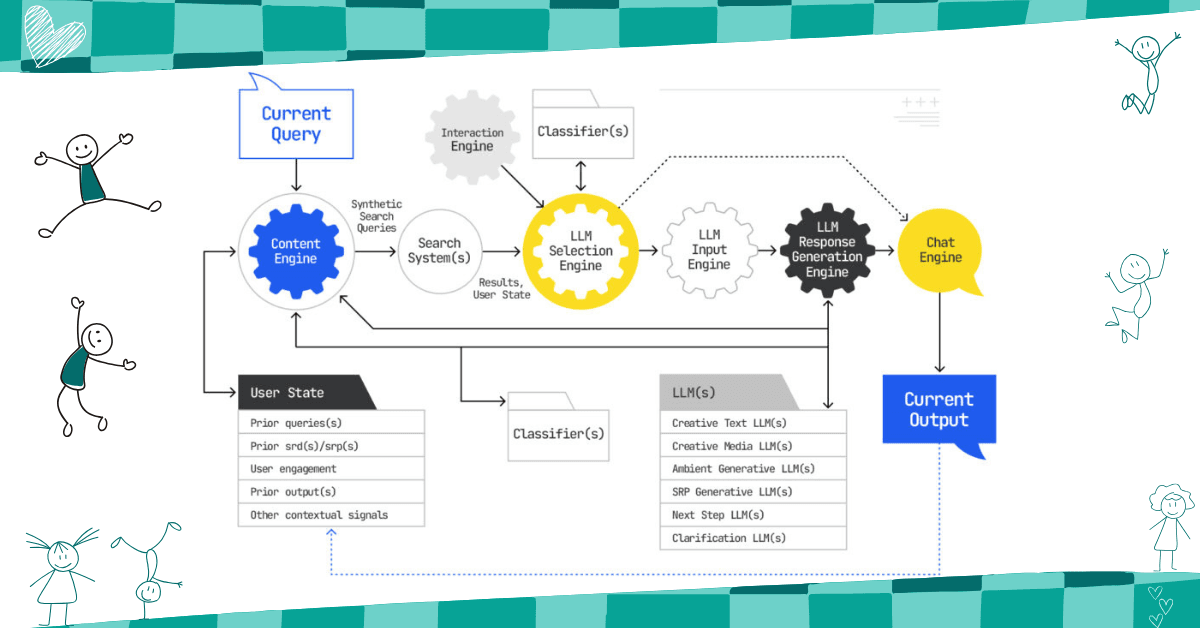

Под поверхностью то, что выглядит как один ответ, на самом деле является балетом машинного мышления. Пользователь вводит запрос, а Google не просто ищет страницы, а генерирует подзапросы (query fan-out). Каждый подзапрос обрабатывается отдельно, извлекая релевантные фрагменты (passages) из индекса.

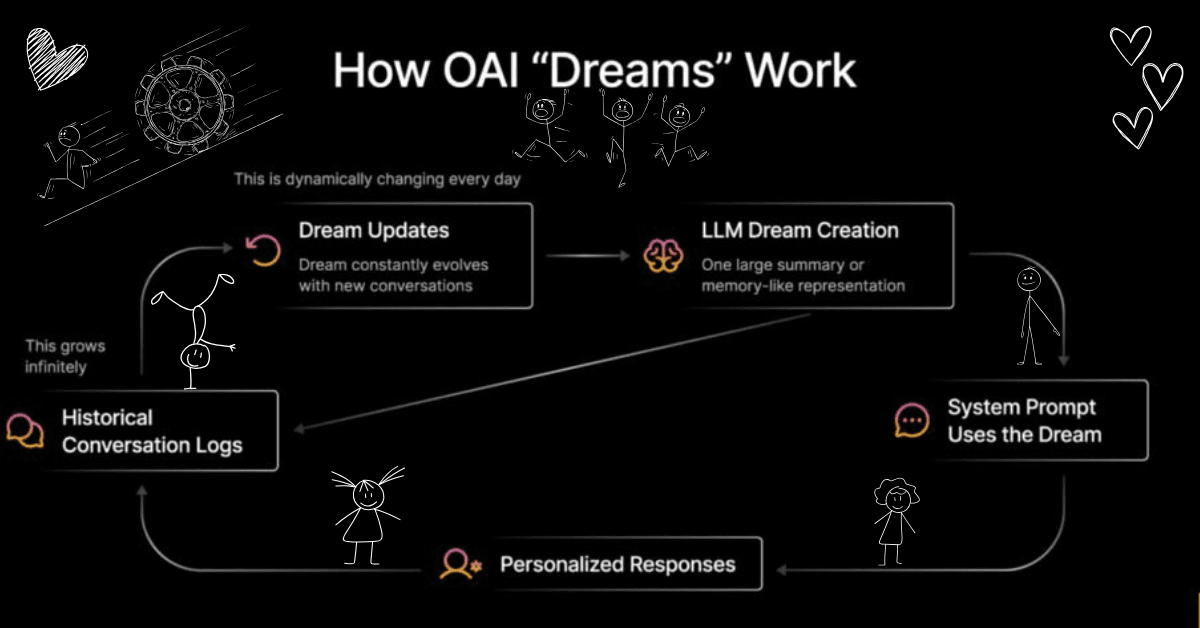

«Stateful chat», или сохранение состояния чата, означает, что Google накапливает фоновую память о вас со временем. Эта память — это агрегированные встраивания, которые представляют прошлые разговоры, темы, которые вас интересовали, и ваши шаблоны поиска. Эта память накапливается и используется для формирования ответов, которые со временем становятся более персонализированными. Запрос — это уже не просто «Какой лучший электрический SUV?», а: «Что означает «лучший» для этого пользователя именно сейчас, с учетом его приоритетов?»

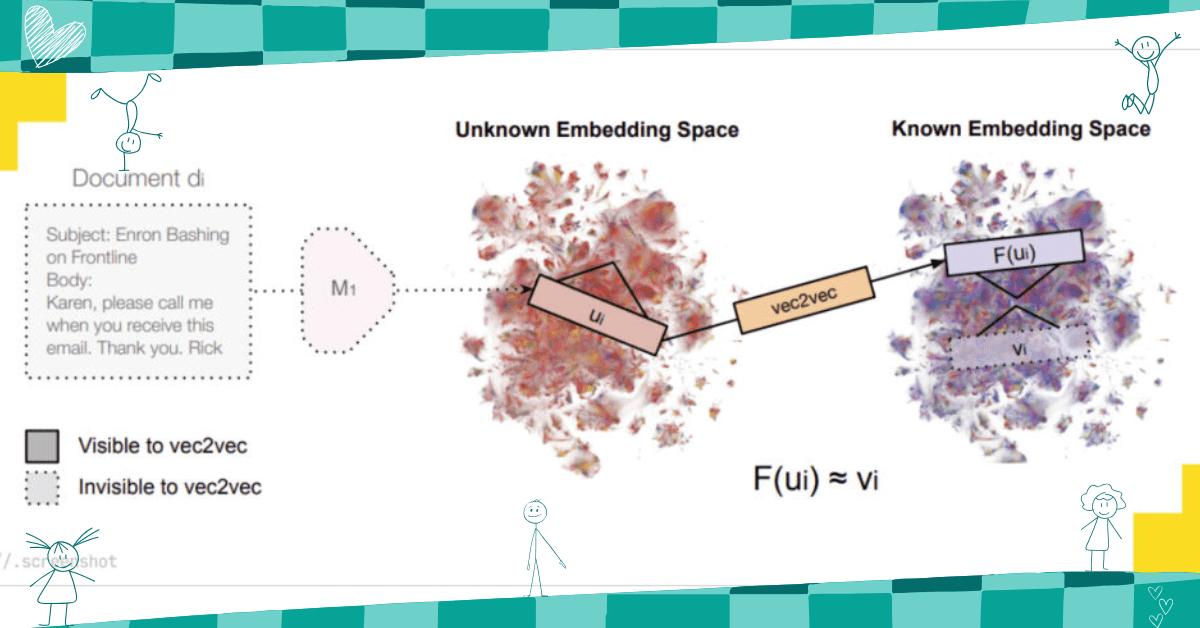

AI Mode персонализирует ответы с помощью векторных представлений пользователя (User Embeddings), описанных в патентной заявке «User Embedding Models for Personalization of Sequence Processing Models». Эта персонализация позволяет Google адаптировать ответы AI Mode под каждого пользователя, не переобучая базовую LLM.

AI Mode — это многоуровневая архитектура, построенная на классическом индексе Google. Вместо обработки каждого запроса изолированно, система сохраняет контекст пользователя: предыдущие запросы, локацию, устройства, поведенческие сигналы. Это все превращается в векторное встраивание, которое позволяет Google понимать намерение не только «сейчас», но и в динамике.

Как формируется ответ:

Когда сформирован кастомный корпус, AI Mode вызывает набор специализированных больших языковых моделей (LLM). Каждая из них имеет свое назначение, которое зависит от типа запроса и предполагаемой потребности пользователя (например, обобщающий, сравнитель, валидационная модель). Финальная модель собирает из них «сценарий» ответа.

Важно: хотя в патенте упоминается LLM, это не классическая архитектура MoE (Mixture of Experts) с одним маршрутизатором. Вместо этого здесь происходит выборочная оркестрация моделей в зависимости от контекста и намерения. Это больше похоже на умную «промежуточную платформу», чем на одну большую модель.

Google больше не ограничивается единственным запросом пользователя. AI Mode использует технику query fan-out, когда один запрос раскладывается на десятки подзапросов. Это изменение всей платформы, где все больше внешнего контекста учитывается. DeepSearch — это фактически расширенная версия DeepResearch, интегрированная в SERP, где могут запускаться сотни запросов и анализироваться тысячи документов.

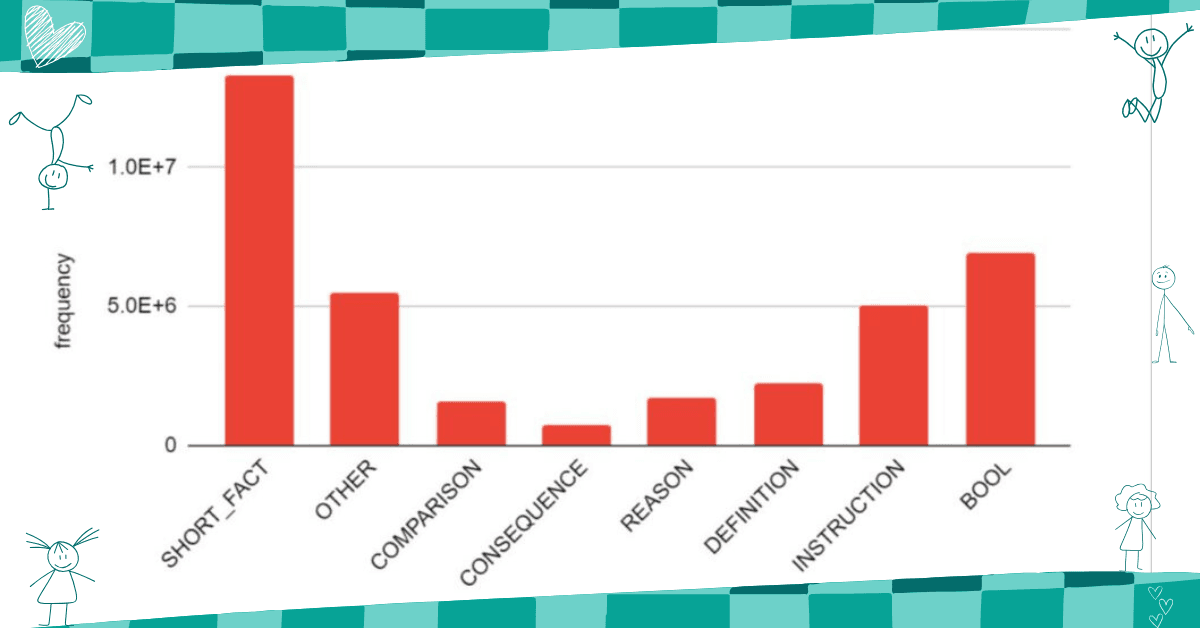

AI Mode использует технику query fan-out, когда один запрос раскладывается на десятки подзапросов:

Например, запрос «лучший электрический SUV» трансформируется в: «обзор Tesla Model X», «сравнение Hyundai Ioniq 5 и Mustang Mach-E», «электромобили с 3 рядом сидений для семьи» и т.д. Каждый такой подзапрос имеет собственный фрагмент ответов.

Каждый подзапрос обрабатывается отдельно, и именно эти фрагменты могут извлекаться из вашего сайта, даже если вы не в топе по основному ключу. Это означает, что поиск становится генеративным, персонализированным и логически структурированным. Ваша веб-страница может быть процитирована, или нет. Ваш контент может появиться не из-за ключевого слова, а потому что одно предложение совпало с каким-то шагом в машинном рассуждении.

Google больше не просто подбирает страницы — он анализирует, рассуждает, формирует логику ответа. В модели reasoning каждый шаг ответа строится как chain-of-thought:

LLM (большая языковая модель) рассуждает, формирует логику ответа (reasoning chain), подбирает лучшие части. Эта магия происходит в невидимой архитектуре, подпитываемой вашим прошлым.

Ранее мы оптимизировали страницы. Теперь нужно оптимизировать фрагменты внутри страницы. AI Mode оценивает не всю страницу, а отдельные пассажи:

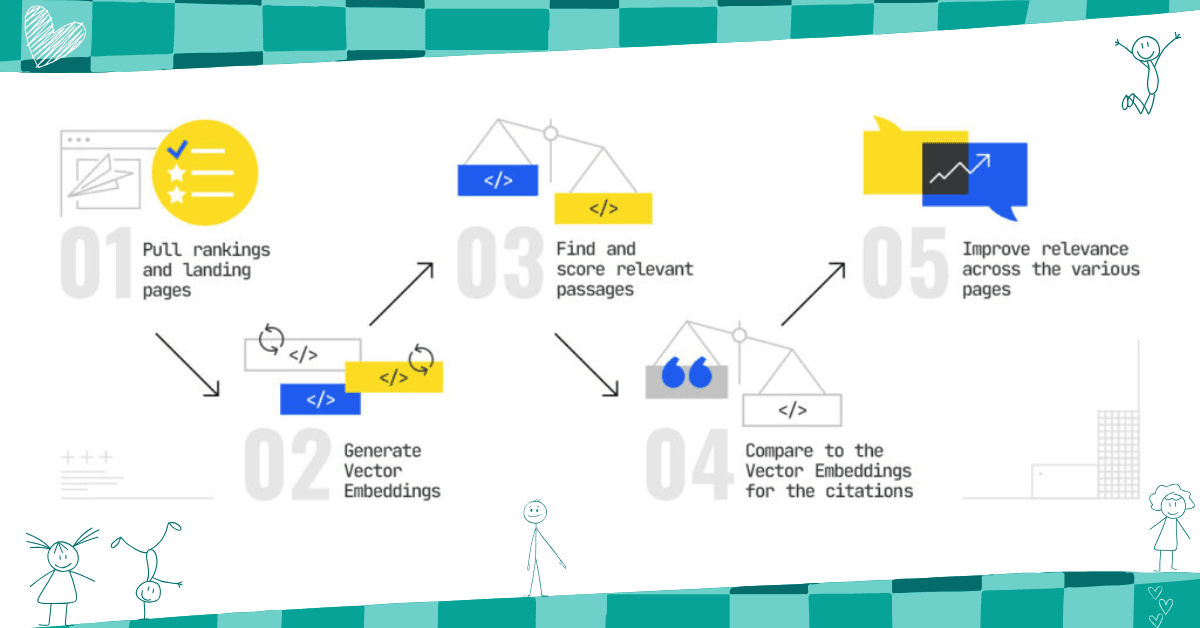

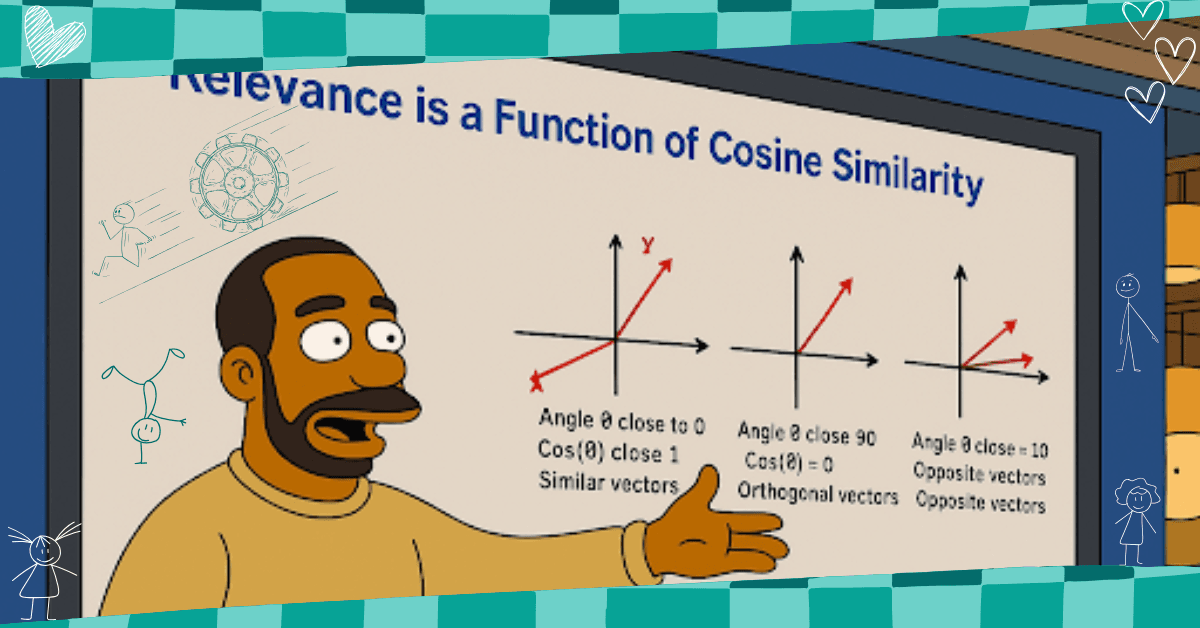

Ваш контент должен быть готов поддержать рассуждения ИИ. Если он нечеткий, противоречивый или не дает ответа на фан-аут-запросы — его просто не будет в ответе. AI Mode использует плотное извлечение (dense retrieval) и семантику на уровне фрагментов (passage-level semantics). Вся эта система работает на основе плотного поиска. Каждый запрос, подзапрос, документ и даже отдельный фрагмент текста (passage) преобразуется в векторное представление.

Согласно патенту «Method for Text Ranking with Pairwise Ranking Prompting», Google разработал систему, в которой LLM сравнивает два фрагмента текста и определяет, какой из них более релевантен запросу пользователя. Этот процесс повторяется для множества пар фрагментов, а затем результаты агрегируются, чтобы сформировать финальный рейтинг. Это — сдвиг от абсолютной оценки релевантности к относительной, вероятностной.

Практически это выглядит так:

Недостаточно просто ранжироваться. Нужно создавать фрагменты, которые смогут выиграть прямое LLM-сравнение. Потому что рассуждение означает, что Gemini делает серию логических выводов на основе истории взаимодействия с пользователем (памяти).

SEO потратило 25 лет на то, чтобы готовить контент для индексации и ранжирования по конкретному запросу. Теперь мы создаем релевантность, которая должна проникнуть в системы рассуждения по целому спектру запросов.

AI Mode внедряет новые механизмы, к которым мы не имеем и вряд ли будем иметь доступ, что делает поиск вероятностным. Поэтому даже если мы создадим технически правильные сайты, напишем контент, выстроим ссылочную массу — это будет лишь один из многих входных сигналов, который в итоге может быть вообще невидимым в финальном результате.

Чтобы создавать контент, готовый к AI Mode, необходимо:

Традиционное позиционное SEO больше не работает. Ваш сайт может быть на 1 месте, но не попасть в ответный. И наоборот — может не быть в топе, но быть выбранным как фрагмент. Текущая SEO-модель больше не соответствует новой реальности, где все руководствуется рассуждением, персональным контекстом и DeepResearch. Google не пытается обеспечить вам трафик, он хочет, чтобы люди получали ответы на свои информационные запросы, и рассматривает трафик как «необходимое зло».

Новые метрики успеха в генеративном поиске:

Персонализация через embedding-профили означает, что выдача зависит от контекста пользователя. Два пользователя, которые задают один и тот же вопрос, могут получить разные ответы. AI Mode теперь — это не просто понимание намерения, а запоминающаяся среда.

AI Mode персонализирует ответы с помощью векторных представлений пользователя (User Embeddings). Это позволяет Google адаптировать ответы AI Mode под каждого пользователя, не переобучая базовую LLM. User embedding применяется при интерпретации запроса, генерации фан-аут-запросов, извлечении фрагментов и синтезе ответа.

Используйте Perplexity как тренажер и тестовую зону. Это единственная платформа, которая позволяет видеть, как LLM выбирает контент и почему.

Коммерческие ниши тоже под ударом: даже в финансах, e-commerce, медицине Google генерирует ответы на основе reasoning. Google уже внедряет кастомную визуализацию данных прямо в выдаче — на основе ваших данных. И если уже сегодня контент может миксоваться на лету с помощью Veo или Imagen, то можно не сомневаться: полноценное ремикширование контента — уже близко.

Мультимодальное будущее поиска означает, что AI Mode изначально является мультимодальным. Система может работать с видео, аудио и их транскриптами, изображениями. Применяется архитектура Multitask Unified Model (MUM), которая позволяет, например, брать контент на одном языке, переводить его на другой и включать в ответ.

Авторитетность теперь на уровне фрагментов: важно не только доверие к сайту, но и качество конкретного абзаца. Это особенно критично для YMYL (Your Money Your Life) контента, где точность, экспертиза и доверие являются первоочередными.

Хотя Google годами предостерегает от оптимизации под ботов, новая реальность буквально заставляет нас относиться к ботам как к главным «потребителям» контента. Именно боты теперь интерпретируют информацию от нашего имени. То есть, тезис Джеймса Кадволладера сводится к тому, что очень скоро пользователь вообще не будет видеть ваш сайт. Агенты будут обрабатывать вашу информацию, исходя из своего понимания пользователя и собственного «мышления» относительно вашего сообщения. Это подчеркивает критическую роль авторитета и точности каждого фрагмента контента.

Мы на распутье. Традиционное SEO еще работает — но чем дальше, тем меньше. Впереди — эпоха семантики, логики, фрагментов и векторов. AI Mode — это вызов, но и возможность для тех, кто умеет мыслить стратегически, строить глубокий контент и не боится адаптации.

Существует глубокий разрыв между тем, что технически нужно, чтобы достичь успеха в генеративном поиске (generative IR), и тем, что реально делает SEO-индустрия сегодня. Большинство инструментов SEO до сих пор работают на основе моделей разреженного поиска (sparse retrieval), вместо плотных моделей поиска (dense retrieval), которые используют векторные встраивания (embeddings).

У нас нет инструментов, которые:

Пришло время активизировать наше сообщество, снова начать экспериментировать и учиться. Те из нас, кто сможет — должны начинать с понимания, как работает технология, и уже тогда возвращаться к стратегии и тактике.

Вся система AI Mode работает на основе плотного поиска, где каждый запрос, подзапрос, документ и отдельный фрагмент текста преобразуется в векторное представление. Google вычисляет сходство между этими векторами, чтобы определить, что будет использовано в генеративном ответе.

Это значит, что теперь важно не просто «попасть в выдачу по запросу», а насколько ваш документ или даже отдельный абзац семантически совпадает со скрытым набором запросов.

Поиск изменился. Теперь очередь за нами.

Да, Google все еще индексирует веб-страницы. AI Mode не заменяет индексацию; наоборот, он активно использует ее. Google извлекает фрагменты ответов именно из индекса, а так называемый «кастомный корпус» формируется из индексированных документов, которые семантически релевантны скрытым подзапросам.

Однако, стоит помнить, что индексация — это лишь первый шаг. Чтобы ваш контент попал в ответный AI Mode, ему нужно пройти еще несколько «фильтров»:

Featured Snippets можно считать предтечей AI Overviews. Их судьба в новой эпохе неоднозначна:

По текущим наблюдениям, Featured Snippets все еще существуют, но:

Авторитетность остается важной, но ее фокус смещается. Теперь она имеет значение преимущественно на уровне источника конкретного фрагмента, а не просто домена в целом.

LLM выбирает фрагменты, которые:

В патентах Google упоминается «quality scoring» для фрагментов — это отдельная метрика для passage, которая может быть выше или ниже средней оценки страницы или сайта в целом. Это означает, что даже если ваш домен имеет высокий авторитет, качество и точность отдельных фрагментов вашего контента являются критически важными.

Так, AI Mode уже активно работает в коммерческих нишах и его влияние будет только расти. Google активно тестирует и внедряет AI Overviews в таких сферах, как:

Однако, есть важные нюансы, особенно для high-risk ниш (YMYL — Your Money Your Life):

Традиционное позиционное SEO уже не работает так, как раньше. Ваш сайт может быть на 1 месте, но не попасть в AI Mode, или наоборот — не быть в топе, но быть выбранным как фрагмент. Поэтому к привычным метрикам добавляются новые, более релевантные для генеративного поиска:

Отчетность в SEO также трансформируется, поскольку фокус смещается с абстрактных позиций на фактическую релевантность и цитируемость. Теперь необходимо отслеживать и показывать клиентам не только динамику позиций по ключевым словам (которая остается базовой, но менее критичной), но и:

Это требует пересмотра привычных дашбордов и внедрения новых инструментов аналитики, способных работать с векторными данными и анализировать генеративные результаты.

Чтобы ваш контент имел высокие шансы быть использованным в сгенерированном ответе AI Mode, необходимо изменить подход к его созданию и оптимизации. Вот ключевые шаги:

В эпоху генеративного поиска традиционные SEO-инструменты адаптируются, но возникает потребность в новых решениях, ориентированных на AI Mode. Вот инструменты, которые стоит отслеживать и использовать:

Инструменты, которые уже эволюционируют / показывают потенциал:

Дополнительные инструменты и подходы, выходящие за пределы традиционного SEO:

Адаптация к новой реальности поиска потребует от SEO-специалистов не только обновления знаний, но и освоения новых инструментов и подходов к анализу данных.